Może komuś się przyda...

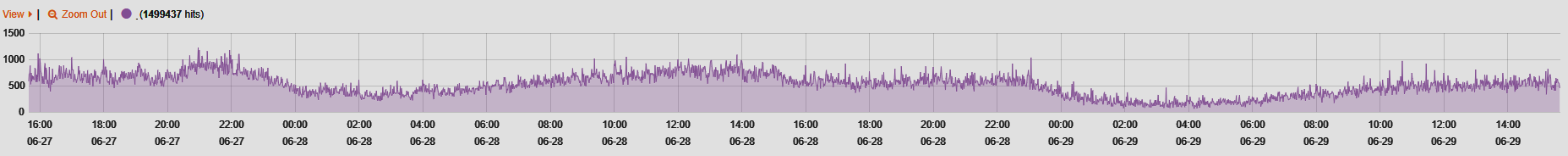

Ostatnio dość mocno i dotkliwie uaktywniły się różnego rodzaju boty, crawlery, spidery i inne dziadostwo intensywnie czytające i oglądające zdjęcia na stronach WWW, niestety jako efekt uboczny nabijające spory ruch na serwerach a nie przynoszący żadnych korzyści. Jeszcze tydzień temu boty generowały mi 80% ruchu. Polubowne działania z robots.txt jednak nie przyniosły widocznego efektu więc postanowiłem rozprawić się z nimi jak dawniej czyli powycinać "zło" po UserAgent.

Proste statystyki z ostatnich 7 dni (na 7 087 450 wejść boty to wciąż 3 129 166): BOTY-od-22-06-do-28-06-analiza.zip

Moja aktualna lista botów blokowanych na podstawie występująych substring'ów w UserAgent:

'yandex','ahrefsbot', 'baiduspider', 'exabot', 'gigabot',

'phpcrawl', 'httpunit', 'libwww', 'python-urllib', 'commons-httpclient', 'psbot',

'naverbot', 'yeti', 'semrushbot', 'nekstbot', 'spbot',

'screaming frog', 'seoscanners', 'scanner', 'spider',

'uptimerobot', 'seznambot', 'ru_bot', 'mojeekbot',

'mj12bot', 'majestic12', 'haosouspider', '360spider',

'webmeup-crawler', 'blexbot', 'siteexplorer', 'ltx71', 'petalbot', 'seekport',

'gptbot','babbar','crawler','bytespider','FriendlyCrawler','serpstatbot','semrush',

'dataforseo.com','anthropic','ClaudeBot','nekst.pl','opensiteexplorer.org',

'Python/','ows.eu/owler','AwarioBot','UptimeRobot','qwant.com/bot','ZoominfoBot',

'GeedoProductSearch','Sogou web spider','Timpibot','crawler_eb_germany_2.0',

'IonCrawl','commoncrawl.org','Dataprovider.com','censys.io'