Nie mam z tym za bardzo doświadczenia, zawsze był jakiś devops obok, który pomagał mi rozwiązywać takie problemy. Teraz jestem sam w projekcie i wolę was zapytać, bo często ktoś tu pomaga.

Opis problemu:

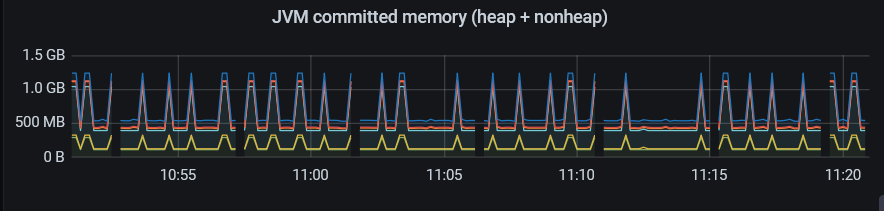

Jest to mała aplikacja, działająca na kontenerze używana przez 1-2 użytkowników(springboot & thymeleaf). Zwiększyliśmy pamięć na aplikację z 600mb do 1gb, bo wyrzucało nam OOM. Po podwyższeniu pamięci serwis działa, ale GC zaczął się odpalać dość często. Pamięć skacze jak na screenie. Większość zajmowanej pamięci to tenured space, który później spada do stabilnego poziomu.

Pytanie:

Jako, że nawet przy praktycznie zerowych requestach i braku jakichkolwiek shedulerów na tym serwisie takie skoki występują, chciałbym zrobić memory dump w okresie wzrostu pamięci. Stąd pytanie: da się zrobić trigger, który uruchomi tworzenie memory dumpa po przekroczeniu, np. 800mb?

Może w złym miejscu szukam powodu? Wszystkie wskazówki przyjmę z pokorą :). Pozdrawiam

- screenshot-20210427112107.png (49 KB) - ściągnięć: 4

Java

Java  Spring

Spring

scibi_92