- A czy już coś próbowałeś (poza wspomnianymi mapami)?

nic. Nie mam już czasu, do końca roku muszę oddać tę moją pracę dyplomową.

Redis fajnie działa jak odpytujesz po kluczu. Jak zaczniesz szukać po tym to może już tak fajnie nie działać. Ile masz tych danych?

będę miał 2 klucze tu, danych, 40 wiadomości co sekundę, z tego przechowywać trzeba może z 200.

Jak to są gołe mapy bez zapisu na dysk i jest za wolne to IMHO są dwie opcje:

- niżej nie zejdziesz bo każdy zewnętrzny komponent oznacza dodatkową serializację (redis) lub serializację i zapis na dysk (postgresql i sqlite)

- coś skopałeś w implementacji, pogubiłeś się na wielowątkowości itd :p

no skopane jest, chyba najbardziej tracę czas przez sprawdzanie nuli, iterowanie po tym cachu i usuwanie starych co każde pobranie. Poza tym te mapy powinienem wynieść do osobnej instancji i na zewnątrz, do nowego serwisu, więc de facto sprowadza się to do implementowania własnej "bazy".

a druga, że nie mam już czasu się w tym babrać, muszę do końca roku złożyć pracę na polibudzie.

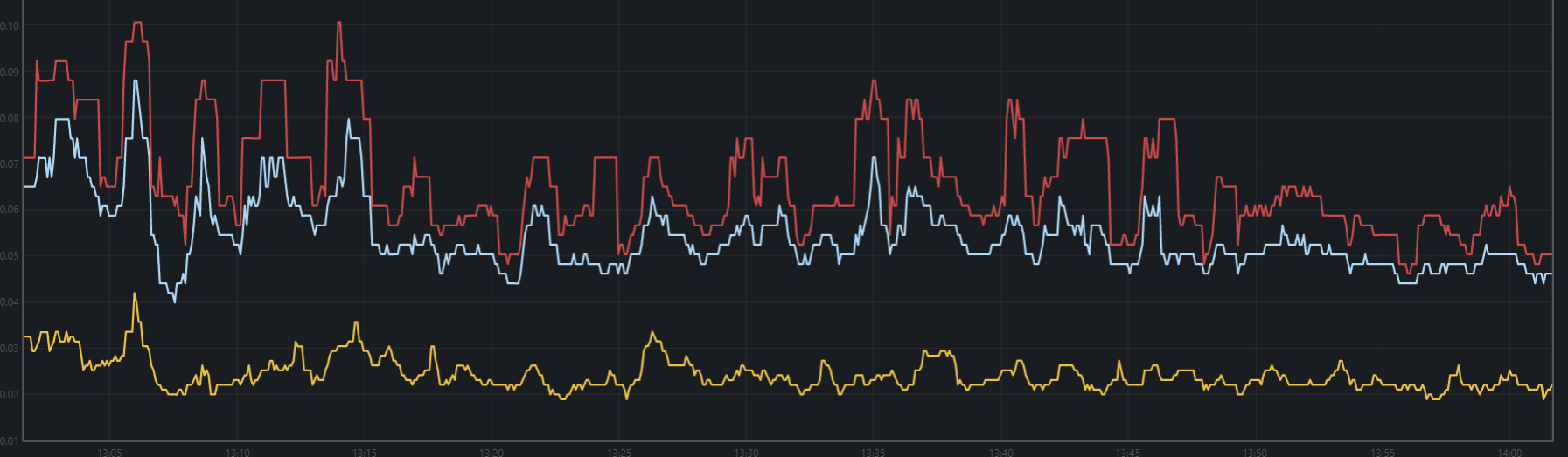

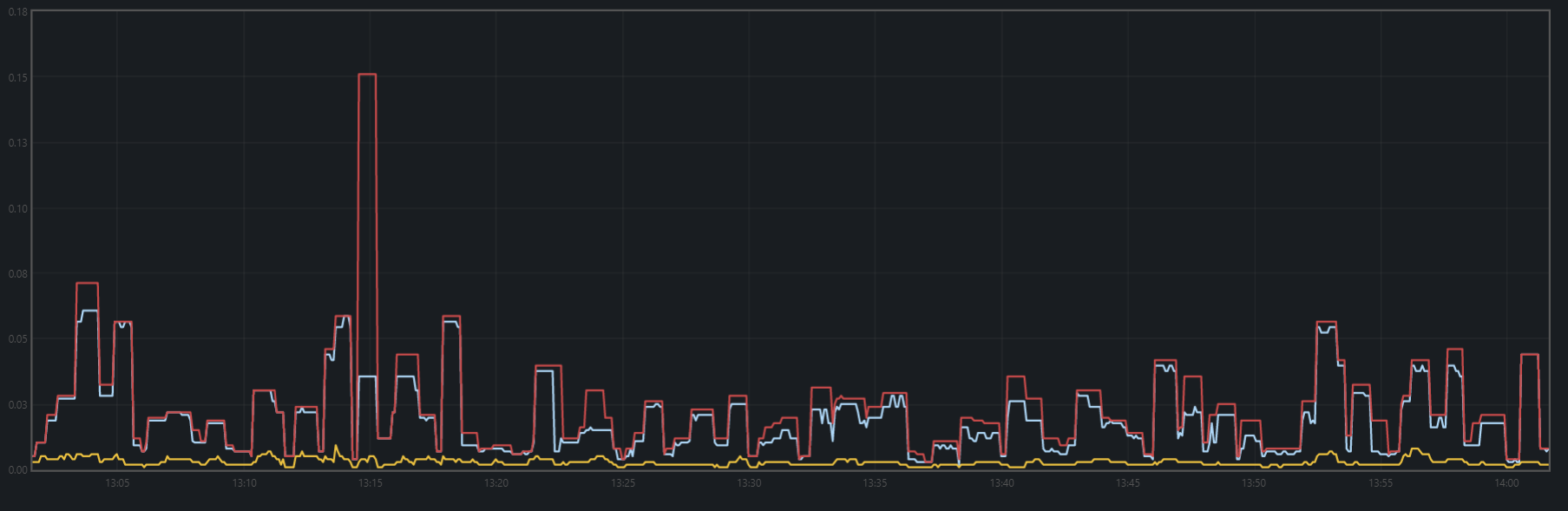

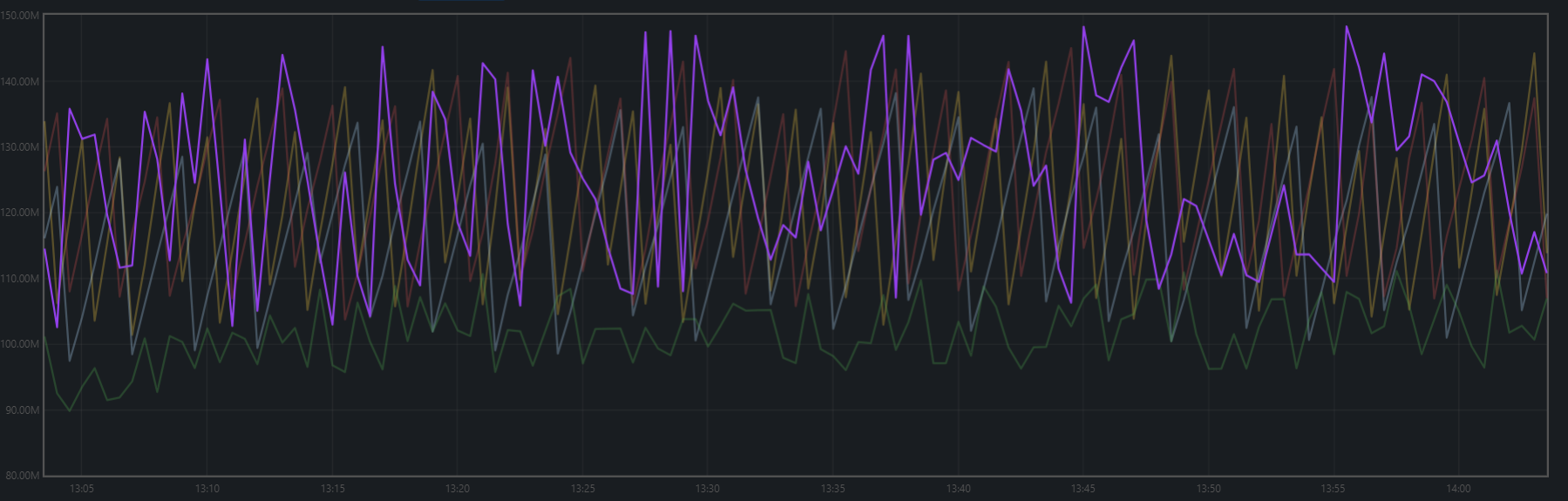

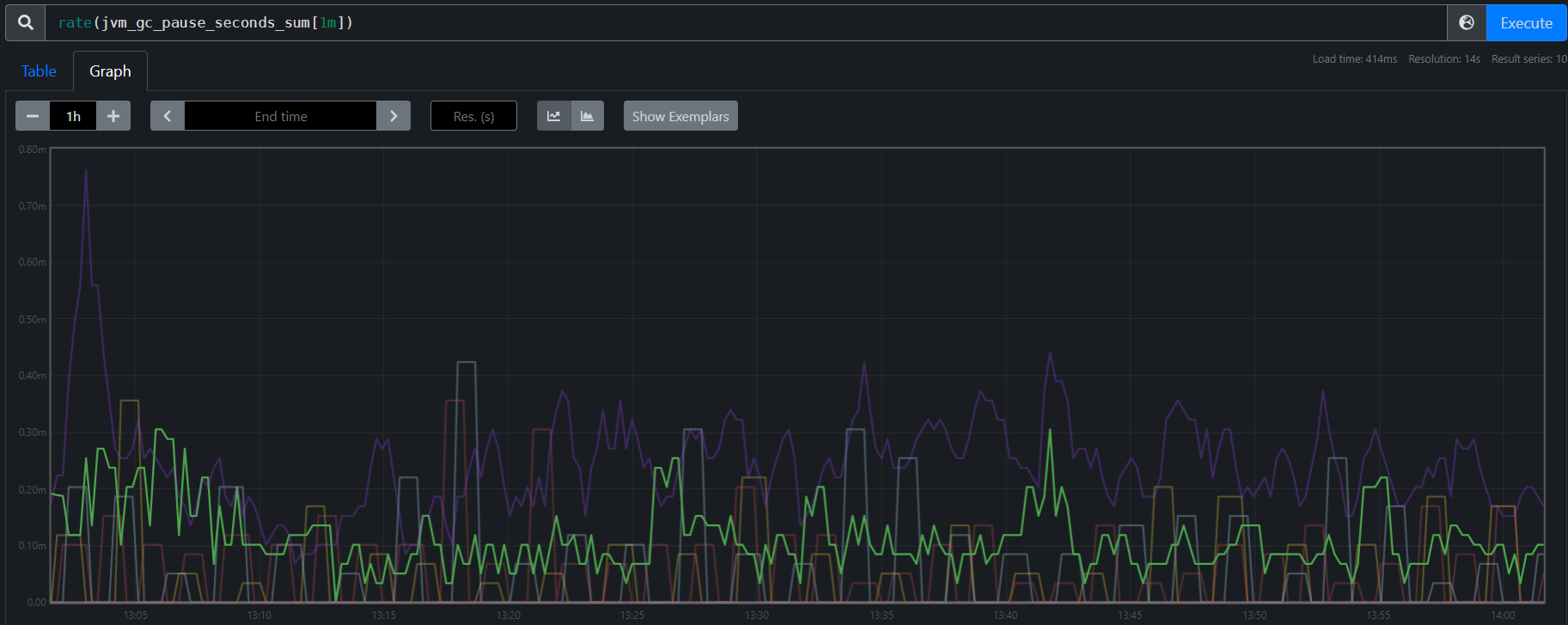

Zostawiłbym to tak, ale wstyd pokazać 60 ms, jak moje inne microserwisy dają radę w 20 - 30.

Aha to wszystko percentyl 99.

To jest praca o Big Data, więc to ma zapierdalać.